Naukowcy z wiodących instytucji, takich jak NVIDIA, Rutgers University, UC Berkeley czy MIT, przedstawili STORM (Spatiotemporal TOken Reduction for Multimodal LLMs) – przełomowy system AI, który redefiniuje sposób, w jaki sztuczna inteligencja analizuje i rozumie długie materiały wideo. Dzięki innowacyjnym technikom redukcji tokenów wizualnych, STORM osiąga ośmiokrotnie niższe koszty obliczeniowe, jednocześnie znacząco poprawiając wydajność.

Problem Zrozumienia Wideo w AI: Redundancja i Koszty

Tradycyjne podejścia wideo-LLM (Large Language Models for Video) często borykają się z wyzwaniem, jakim jest obsługa długich sekwencji wideo. Każda klatka generuje znaczną ilość danych, a wiele z nich jest redundantnych – niewiele pikseli zmienia się między kolejnymi ujęciami. Ta nadmierna ilość danych wizualnych prowadzi do nieefektywności w przetwarzaniu i wysokich kosztów obliczeniowych, utrudniając rozumienie wideo AI w praktycznych zastosowaniach.

Mamba w Akcji: Nowy Projektor Czasowy

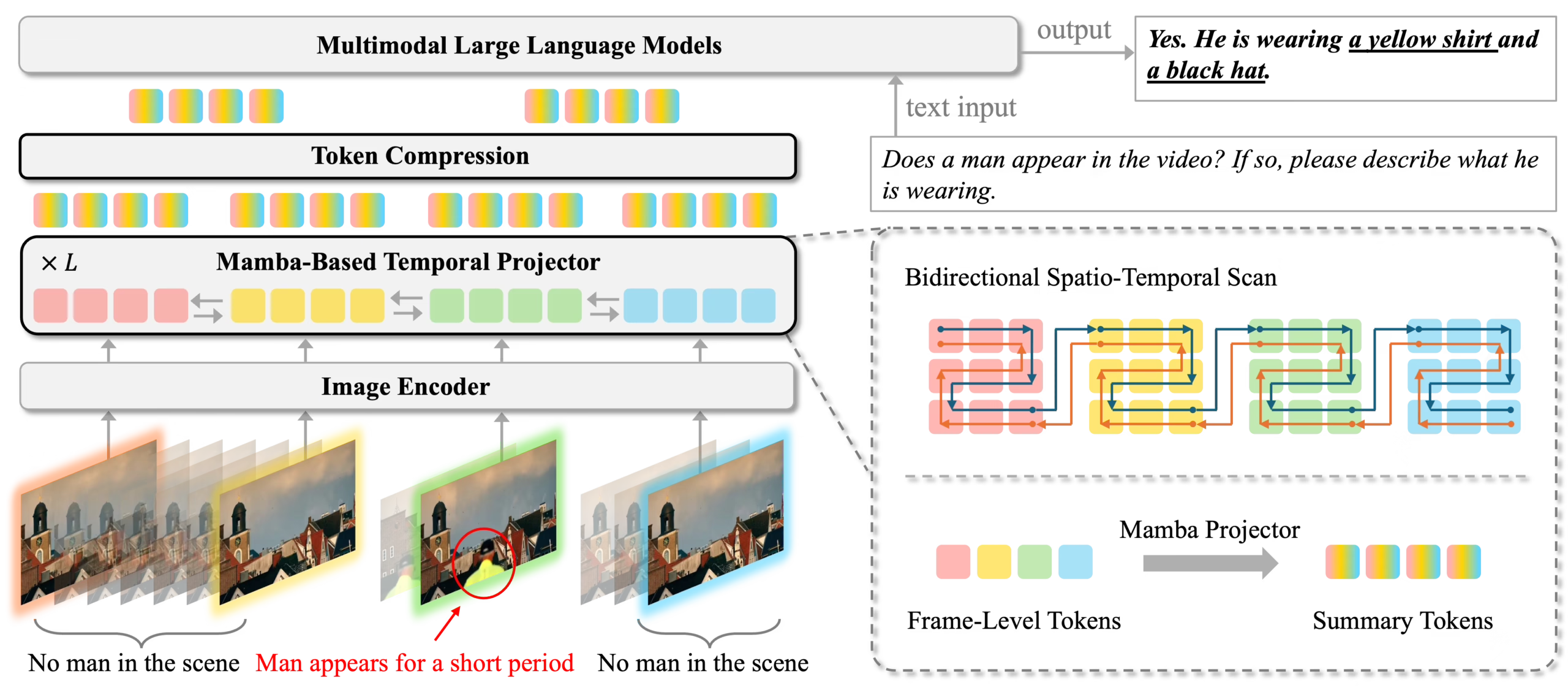

STORM wprowadza innowację w postaci projektora czasowego opartego na Mamba (Mamba-Based Temporal Projector). Ten kluczowy komponent, umieszczony między koderem obrazu a LLM, wzbogaca tokeny wizualne o dynamikę czasową. Takie podejście przynosi podwójną korzyść:

- Poprawione rozumowanie wideo: Model lepiej rozumie złożone relacje i zmiany w czasie, co zwiększa jego zdolności do analizy wideo.

- Efektywna redukcja tokenów: Wzbogacone tokeny zachowują kluczowe informacje, co pozwala na ich dalszą kompresję. STORM wykorzystuje zarówno próbkowanie w czasie wnioskowania, jak i oparte na treningu techniki pulowania przestrzennego i czasowego, by znacznie zredukować ilość danych wejściowych dla LLM.

Architektura STORM: Klucz do Wydajności

System STORM opiera się na trzech głównych komponentach, które wspólnie zapewniają jego wydajność:

- SigLIP Vision Transformer: Wstępnie wytrenowany transformer wizyjny przekształca każdą klatkę wideo w 256 tokenów obrazu.

- Projektor Czasowy Oparty na Mamba: Odpowiada za integrację informacji przestrzenno-czasowych i uśrednianie tokenów z 4 kolejnych klatek, redukując ich liczbę czterokrotnie.

- Qwen2-VL LLM: Ten wstępnie wytrenowany duży model językowy przetwarza skompresowane tokeny, przewidując kolejne słowo w powiązanym tekście wideo.

Podczas fazy wnioskowania, STORM idzie o krok dalej, podając do LLM tokeny reprezentujące co drugą klatkę. Dzięki tej dwuetapowej kompresji, LLM przetwarza zaledwie 1/8 pierwotnej liczby tokenów wizualnych, co przekłada się na szybsze przetwarzanie wideo AI i znaczące oszczędności obliczeniowe.

Wyniki, Które Mówią Same za Siebie

STORM demonstruje swoją przewagę w kluczowych benchmarkach rozumienia wideo:

- MVBench: W teście oceniającym rozumienie akcji i interakcji w 16-sekundowych filmach, STORM osiągnął 70.6% dokładności, wyprzedzając GPT-4o (64.6%) i Qwen2-VL (67.0%).

- MLVU: W teście analizującym bardzo długie filmy (do ponad 2 godzin), STORM uzyskał 72.9% dokładności, przewyższając GPT-4o (66.2%).

Te wyniki potwierdzają, że STORM jest w stanie zapewnić najnowocześniejsze rozumienie wideo przy jednoczesnym znacznym obniżeniu obciążenia obliczeniowego.

Znaczenie i Przyszłość Rozumienia Wideo AI

STORM to przełom w dziedzinie multimodalnej AI, pokazujący, że połączenie architektur Mamba z transformerami może przynieść ogromne korzyści w przetwarzaniu długich filmów. Efektywność i precyzja STORM otwierają nowe możliwości dla zastosowań AI, takich jak:

- Inteligentny monitoring wideo

- Automatyczna analiza treści filmowych

- Tworzenie zaawansowanych systemów rozpoznawania zdarzeń

- Usprawnienie procesów edycji wideo

Jesteśmy świadkami rozwoju coraz bardziej wydajnych systemów, które mogą zrewolucjonizować sposób, w jaki maszyny interpretują i wykorzystują dane wizualne.onitoringu, tworzeniu multimediów i wielu innych obszarach.